스캐터랩, 서비스 중단하고 알고리즘 개선 등 시스템 전반 보완 예정

이재웅 "차별금지법 제정, AI 학습시키는 인간의 규범·윤리 보완해야"

전문가들 "미래 기술이 우리사회에 미치는 영향·역할 등 재정립 필요"

![[사진=스캐터랩 홈페이지 캡처]](https://cdn.newsquest.co.kr/news/photo/202101/80890_57598_1352.jpg)

【뉴스퀘스트=김보민 기자】 사회적 약자를 대상으로 혐오발언을 쏟아낸 데에 이어 개인정보 유출 논란에 휩싸인 인공지능(AI) 챗봇 '이루다'의 서비스가 결국 중단된다.

전문가들은 이번 사태를 계기로 "챗봇·채용·뉴스 등 생활 전반에 AI가 스며들고 있는 지금, 미래기술이 우리 사회에 미치는 영향과 역할에 대해 다시 한번 재고해볼 필요가 있다"고 입을 모은다.

스캐터랩은 11일 저녁 자사의 챗봇 '이루다'의 서비스를 전면 중단하겠다는 입장문을 내놓으며 이용자의 의견을 수렴해 알고리즘 등 시스템을 개선하겠다고 밝혔다.

스캐터랩은 "AI가 5년 안에 인간 수준에 가까운 대화를 할 수 있다고 믿는다"며 "앞으로는 AI가 소외된 사람, 사회적 약자의 마음을 위로해주는 따뜻한 대화 상대가 되길 바란다"라고 말했다.

하지만 업계에선 이번 사건을 계기로 단순하게 시스템을 개발하는 데 그칠 것이 아니라 인공지능 기술이 일으킨 논란들을 반면교사 삼아야 한다고 주장하고 있다.

실제로 인공지능은 데이터를 빠르게 분석하고 추천하는 등의 순기능을 하고 있지만, 반대로 차별을 심화시키는 논란을 계속해서 일으켜왔다.

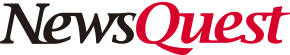

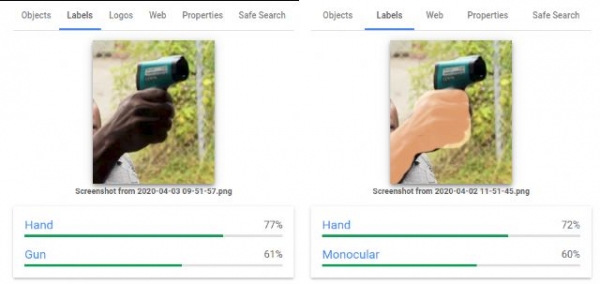

일례로 구글은 작년 4월 이미지를 분석해 어울리는 단어를 기록하는 데이터 라벨링 기술을 접목한 '비전 AI'를 선보였지만, 비슷한 사진임에도 불구하고 인종에 따라 다른 분석을 내놓아 비판을 받았다.

또한 지난해 6월 미국 해리스버그대학교 연구진은 안면인식 소프트웨어와 같은 인공지능 분석기술을 활용하면 모든 사람들의 잠재적 범죄성을 예측할 수 있다고 주장해 논란을 일으켰다.

이런 문제는 최근에만 일어난 것이 아니다.

지난 2018년 미국 전자상거래업체 아마존이 개발한 AI 채용시스템도 이력서에 '여성'이란 문구가 있으면 감점 처리를 해온 사실이 밝혀지면서 서비스 도입이 전면 취소된 바 있다.

전세계에서 인공지능의 사회적책임 등에 대한 문제가 대두되는 가운데 전문가들은 인공지능 기술의 역할에 대해 다시 한번 점검해볼 필요가 있다고 입을 모았다.

미국 코넬대학교 연구팀도 지난 1일 학술자료를 통해 "기존 AI 알고리즘 기술은 편향성 문제를 고치는 데만 주력했다"며 "지속가능한 가치를 창출하고 신뢰를 더하기 위해선 앞으론 'AI 무관심'을 개선하는 데 초점을 둬야할 것"이라고 조언했다.

이재웅 전 쏘카 대표는 12일 자신의 페이스북을 통해 '이루다' 서비스를 중단한 것을 칭찬하며 "이번 사건을 계기로 챗봇, 면접·채용, 뉴스추천 등 AI가 인간에 대한 차별과 혐오를 조장하고 있는 것이 아닌지 사회적으로 점검해야 한다"고 말했다.

이어 "포괄적 차별금지법 제정 등을 통해 AI를 학습시키는 우리 인간들의 규범과 윤리를 보완하면 좋겠다"고 했다.